11. Contributi: Caos, complessità ed autorganizzazione.

Una provocazione al confine tra scienza, tecnologia e cultura*

di Mauro Annunziato**

Tornate all'indice degli articoli

Tornate alla sala saggistica

Il concetto di Caos ha sempre avuto una connotazione prevalentemente negativa essendo il più delle volte contrapposto al concetto di ordine. Malgrado ciò, il caos ha sempre rappresentato qualcosa di affascinante per molti poeti ed artisti che vedevano in questa immagine evocativa non soltanto la degenerazione dell'ordine, ma anche quel contesto denso di potenzialità da cui può emergere la forma, la creazione.

Forse fu proprio questo fascino ambiguo a spingere alcuni scienziati [Yorke, 1972] a definire Chaos una serie di idee che apparentemente contraddicono l'accezione corrente. Da allora questa teoria ha profondamente influenzato gli ambienti scientifici e culturali e sta producendo, si potrebbe dire, una rivoluzione in alcuni paradigmi di pensiero.

In questo articolo di carattere introduttivo ci proponiamo di illustrare alcuni concetti fondamentali quali attrattori caotici e auto-organizzazione, cercando, attraverso degli esempi intuitivi, di evidenziare il carattere di interdisciplinarietà e l'impatto culturale e tecnologico che queste teorie stanno promuovendo in molti campi della conoscenza.

Senza volere evidentemente esaurire in questo breve articolo tutto l'argomento e i diversi interessi culturali che ad esso fanno riferimento, in alcuni riquadri si daranno dei cenni storici sui percorsi di sviluppo delle conoscenze fisiche avutisi sui sistemi dinamici (riquadro 1) e sui sistemi complessi (riquadro 2). Nel riquadro 3 si farà una panoramica dei principali istituti di ricerca impegnati su questi argomenti con sviluppo di conoscenze teoriche e applicative.

Caos Deterministico e cambiamento di paradigma

Il termine Caos Deterministico, in campo scientifico, fu riferito ad alcuni sistemi dinamici non lineari (sistemi caotici) che pur essendo impredicibili e apparentemente incomprensibili per la loro complessità, nascondono un ordine interno che può essere rivelato con un approccio molto diverso da quello utilizzato nella scienza lineare.

Il primo paradosso è che i sistemi caotici sono in realtà ordinati pur essendo impredicibili. Essi possono essere considerati una ampia fascia di sistemi situati tra i sistemi lineari ed i sistemi randomici (mancanza totale di correlazione tra due campioni successivi).

Il secondo paradosso fu l'uso dell'aggettivo Deterministico per sottolineare il fatto che la mancanza di predicibilità di questi sistemi non è dovuta a forze o rumori esterni al sistema, ma dipende da una caratteristica intrinseca del sistema stesso: la elevata sensibilità alle condizioni iniziali.

Questa definizione fondamentale, significa che nei sistemi caotici, cambiando anche di poco le condizioni iniziali, la evoluzione della dinamica del sistema cambia notevolmente nel tempo. Poiché le condizioni iniziali non possono, in pratica, essere conosciute con precisione infinita, questo significa che anche possedendo un modello esatto del sistema (i.e.: tutte le equazioni che descrivono il sistema), nella grande maggioranza dei casi non sia possibile prevedere la evoluzione di un sistema per un tempo lungo. In alcuni semplici sistemi caotici [mappa di Bernouilli] si può addirittura mostrare che la memoria delle condizioni iniziali viene inesorabilmente persa nel tempo.

In poche parole il futuro non è determinato o determinabile; le equazioni della dinamica dei sistemi caotici non sono sufficienti a descrivere completamente i fenomeni; il caos nasconde strutture ordinate; il determinismo non significa di per se predicibilità.

Attrattore ed ordine

Il secondo tassello del mosaico del Caos è costituito dalla nozione di attrattore. Questo termine rappresenta un concetto molto importante per capire il tipo di ordine dei sistemi caotici.

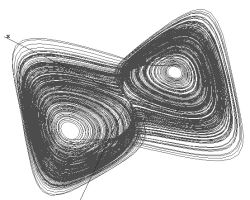

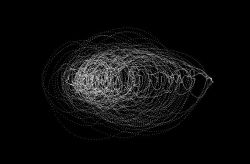

Per definire l'attrattore si ricorre ad uno spazio di stato in cui sono rappresentate le variabili dinamiche del sistema. Per alcune considerazioni che verranno illustrate successivamente, si utilizza lo spazio delle fasi in cui sono rappresentati i valori di una grandezza e delle sue derivate rispetto al tempo. Il numero di dimensioni dello spazio delle fasi dipende dal numero di equazioni differenziali che modellizzano il sistema. Nello spazio delle fasi la variabile temporale è implicita e la dinamica dei sistemi regolari può essere rappresentata da punti fissi o cicli limite (percorso costante nel tempo). I sistemi caotici presentano invece fasci di traiettorie. Poiché ogni punto dello spazio rappresenta una funzione di stato del sistema, due traiettorie diverse non possono avere punti in comune (altrimenti dovrebbero coincidere). In fig. 1 abbiamo riportato uno degli attrattori più noti: l'attrattore di Lorenz [Lorenz, 1963].

Fig. 1: Attrattore di Lorenz: ogni traiettoria dell'attrattore è in realtà composta da due traiettorie molto vicine che divergono nella evoluzione dinamica del sistema.

Le traiettorie che hanno punti molto vicini (condizioni iniziali molto simili) divergono nel tempo formando un intreccio molto articolato. Malgrado questo potrebbe far pensare ad un sistema del tutto casuale e impredicibile, i fasci di traiettorie nello spazio delle fasi mostrano delle strutture organizzate. È come se le linee che rappresentano la dinamica del sistema si conformassero ad un ordine superiore definito dal luogo dei punti dello spazio visitati dal sistema cui è stato dato il nome di attrattore. Il termine sta ad indicare che il sistema tende (viene attratto) verso un modello di comportamento dinamico senza però ripetersi in modo identico.

Le potenzialità applicative

Per chiarire meglio la portata dei concetti espressi di sistema caotico ed attrattore faremo alcuni esempi applicativi.

Il primo esempio riguarda un sistema caotico per eccellenza: l'uomo. L'esempio che introduciamo è tratto da un lavoro della psicologa Elena Liotta (della Society for Chaos Theory in Psychology and Life Sciences) la quale, per monitorare l'andamento dei suoi pazienti utilizzava il gioco della sabbia che consiste nel chiedere al paziente di disporre oggetti e tracciare forme su un tavolo di sabbia inizialmente omogeneo. Con questa metodologia è stata raccolta una notevole quantità di materiale (fotografie). Il materiale ha dimostrato in modo molto emblematico come le persone procedessero attraverso una dinamica di costruzione della composizione e delle forme che si ripeteva in modo simile in diverse sedute. Essi rispondevano ad una sorta di attrattore psichico interno che guidava le loro costruzioni e cambiava forma con il procedere della terapia. Espresso in termini semplici, la psicologa si era dotata di un ulteriore strumento per monitorare i cambiamenti nell'attrattore durante le terapie.

Facendo un piccolo salto di fantasia, proviamo ad immaginare dei pittori al posto dei pazienti e dei quadri al posto del gioco della sabbia. In questo caso ciò che noi percepiamo come stile pittorico raggruppando diversi dipinti di uno stesso pittore, è strettamente connesso alle modalità della costruzione dinamica della forma e del colore. L'astrazione che siamo in grado di compiere potrebbe essere riferita alla percezione di un attrattore creativo specifico per ogni artista che potrebbe essere astratto dalle opere.

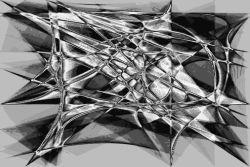

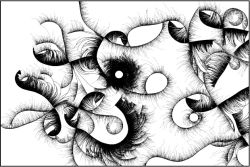

Nell'esempio riportato in figura 2, si è lasciato evolvere un sistema caotico non-lineare e tracciata la densità dell'attrattore (probabilità di passaggio in una determinata zona dello spazio di stato) associando un diverso colore ai differenti valori di densità. Benché il sistema di generazione (non lineare) fosse abbastanza semplice, le forme che emergono sono molto articolate e ricordano lo stile dei cubisti. Lo stesso metodo è stato utilizzato per generare diverse composizioni caratterizzate da uno stile che dipende dal sistema di equazioni utilizzate per la sua generazione. In questo ultimo esempio, si è fatto un percorso inverso rispetto al concetto di attrattore creativo precedentemente espresso: prima si crea lo stile e poi si generano le opere. In realtà l'artista digitale costruisce e seleziona tra gli infiniti stili possibili quello a lui più congeniale tradendo cosi il proprio stile creativo.

Fig. 2: Violin Dance (Annunziato, 1996): La vibrazione di un violino cubista nella danza di un attrattore di un sistema di equazioni non lineari.

Facciamo ora un ulteriore salto di fantasia, stavolta un pò più arduo, e sostituiamo al pittore una macchina. È ormai chiaro che l'attrattore dinamico ne caratterizza l'evoluzione temporale che risponde ad una essenza interna. Riuscire a ricostruire l'attrattore significa riuscire a trovare un ordine nella dinamica apparentemente randomica della macchina e quindi riuscire a discernere nel caos degli eventi, in quale stato si trova ad operare e in quale stato sta per evolvere. La macchina può essere un qualsiasi impianto industriale o un prodotto tecnologico.

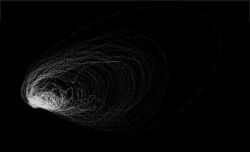

Nel nostro caso sono state prese in considerazione diverse macchine tra cui i processi di combustione ed i processi multifase. Per affrontare questi temi è stata sviluppata una tecnica innovativa (dynamics moments) nell'ambito di una collaborazione tra ENEA e l'Institute for Non Linear Science (INLS) della California University San Diego (in particolare con il Prof. Abarbanel). Il metodo si fonda sulla descrizione della sulla evoluzione morfologica degli attrattori [Annunziato, Abarbanel, 1999]. Questa tecnica di classificazione è stata utilizzata per costruire sistemi di diagnosi e controllo per impianti di estrazione e trasporto di idrocarburi [Annunziato, Bertini, Pizzuti, 1997; Annunziato, Bertini, Pizzuti, 1998] (fig. 3) e per monitorare indirettamente le condizioni operative e di impatto ambientale di bruciatori industriali (fig. 4).

Fig. 3: Attrattore del segnale di un sistema per la diagnostica di pozzi petroliferi installato presso l'area petrolifera dell'AGIP di Trecate (NO) in una condizione particolarmente critica per l'impianto (slug flow). Il sistema, sviluppato nell'ambito di un contratto europeo Thermie, è attualmente installato ed operativo sul campo petrolifero.

Infine, con un ultimo salto, sostituiamo alla parola macchina la parola sistema, visto come un complesso di elementi che evolvono ed interagiscono causando un comportamento complessivo generalmente molto articolato (sistemi complessi).

Anche in questo caso si possono fare molti esempi che possono sembrare paradossali come quello di progettare un basilica attraverso una generazione genetica dei componenti architettonici [Soddu, 1993] a quelli molto significativi della previsione dell'andamento dei titoli di borsa e dei flussi monetari o della progressione del virus dell'AIDS per finire alla gestione delle risorse umane e alla comunicazione.

Fig. 4: Attrattore del segnale di un sensore ottico a fotodiodo per la misura del rilascio termico (sviluppato in ENEA), installato su un impianto sperimentale ENEA (COMET) per la qualificazione di una camera di combustione per turbine a gas progettata dalla Nuovo Pignone.

Auto-organizzazione, struttura e sistemi

Proprio gli ultimi esempi sui sistemi complessi ci servono per introdurre il secondo dei concetti fondamentali della teoria della complessità: l'Auto-Organizzazione.

L'Auto-Organizzazione è la proprietà manifestata da alcuni sistemi complessi formati da molteplici elementi che interagiscono tra loro, di sviluppare strutture ordinate da situazioni caotiche. Questi sistemi sono capaci di creare organizzazione e strutturazione facendo crescere la complessità interna anche quando i singoli elementi del sistema si muovano in modo autonomo e in base a regole puramente locali. Secondo un definizione data da Klir [Klir, 1991]: "un sistema auto-organizzante è un sistema che tende a migliorare le sue capacità nel corso del tempo organizzando meglio i suoi elementi per raggiungere l'obiettivo". Essi sono sistemi (orientati all'obiettivo) capaci di migliorare le loro prestazioni, senza un aiuto esterno, mentre stanno tendendo verso l'obiettivo.

Poiché la definizione dell'obiettivo è funzione delle proprietà comportamentali che si vogliono osservare, la definizione non è univoca ma piuttosto qualitativa. Generalmente per comportamento auto-organizzante si intende la formazione spontanea di strutture e patterns indipendentemente dalle condizioni iniziali. Malgrado siano sistemi dinamici con elevato numero di elementi e variabili, quindi con uno spazio di stato molto ampio, essi tendono a concentrare il proprio attrattore in una porzione limitata dello spazio.

Tra i sistemi auto-organizzanti, una classe a parte sono quei sistemi che hanno al loro interno meccanismi genetici che mettono in atto un altro principio di adattamento: quella della selezione naturale. Queste caratteristiche, tipiche dei sistemi formati da individui viventi, conferiscono al sistema una dimensione in più esaltando la strutturazione della complessità interna nella direzione dell'adattamento.

Nagual Experiment: un esempio limite di auto-organizzazione

L'esempio che riportiamo, cerca di dare una illustrazione diretta e visuale dei concetti di auto-organizzazione ed evoluzione genetica. Questi meccanismi sono più facili da spiegare servendosi di immagini e di intuizione, pertanto cercheremo di sottolineare il carattere qualitativo dell'esempio più che le regole implementative.

Il nome di questo esperimento si riferisce ad un antico mito (Nagual) della cultura tolteca, attualmente diffuso tra gli sciamani nell'America latina [Castaneda, 1972]. Il Nagual, che rappresenta la parte sconosciuta dell'individuo, è responsabile delle potenzialità creative e percettive dell'individuo attraverso la coordinazione di tanti elementi autonomi di percezione (di qui la metafora con il concetto di auto-organizzazione).

L'esperimento consiste nella evoluzione di una popolazione di individui, rappresentati come filamenti neri, i quali si sviluppano (crescendo in una direzione) su una immagine inizialmente bianca (spazio vitale). Ogni individuo è descritto da una serie di caratteristiche genetiche (genotipi) che influenza la modalità di crescita (basato su un modello randomico-probabilistico dello spostamento) e le probabilità di auto-riproduzione (nascita di un filamento figlio) e di morte (termine della crescita). Infine, dei vincoli ambientali (libertà degli individui di cambiare direzione e numero totale degli individui viventi) influiscono sulla dinamica dell'intera comunità.

Il fenotipo, cioè la modalità di interazione con gli altri individui, è fisso e uguale per tutta la popolazione e consiste in una semplice regola: se un individuo incontra un altro individuo, termina la sua crescita (morte) e la sua scia rimane impressa nell'immagine. Per questo motivo durante la evoluzione, lo spazio vitale diminuisce e, dopo un certo tempo di sviluppo, l'evoluzione si conclude.

Questo esperimento può essere inquadrato in quei sistemi cosiddetti di crescita frattale (fractal growth [Vicsek, 1991]) particolarmente significativi per la modellizzazione di agglomerati, sistemi organici e crescita granulare nei materiali.

Il sistema è caratterizzato da un flusso di energia (rappresentato dalle nascite e morti), dissipazione e disequilibrio (la riduzione continua dello spazio vitale) e quindi ha gli ingredienti fondamentali per sviluppare caratteristiche di autorganizzazione.

Fig. 5: Nagual Experiment: risultato finale di una evoluzione di crescita. Si può notare il pattern coerente dell'intera immagine, la complessa strutturazione interna e l'azione degli individui dominanti che con il loro movimento tracciano i bordi delle zone interne.

L'emergere della auto-organizzazione

Benché gli individui si muovano in modo del tutto autonomo, la dinamica complessiva porta nella stragrande maggioranza dei casi a configurazioni che hanno una struttura complessiva coerente e molto articolata nel suo interno.

Nella fig. 5 é riportato un esempio di evoluzione.

Variando i parametri della evoluzione e le caratteristiche genetiche degli individui si ottengono patterns molto diversi generalmente riconducibili alla crescita di popolazioni o a fenomeni di propagazione (piante, agglomerati animali, reti neuronali, bacini idrici, fratture, crescita granulare) e, in alcuni casi, alla genesi di forme antropomorfe.

Tutte le forme generate, sono caratterizzate da una differente distribuzione nello spazio e differenti caratteristiche delle linee (dimensioni frattali) e delle giunzioni. La forma finale (pattern) emergente dal processo di evoluzione è fortemente connessa con la dinamica della crescita.

Durante l'evoluzione, si verificano forti cambiamenti improvvisi (biforcazioni) nella modalità di colonizzazione dello spazio. Zone molto dense sono alternate a zone a bassa densità. Questo meccanismo, nella maggior parte dei casi è dovuto all'azione di individui dominanti che agiscono come pionieri colonizzando nuovi spazi e creando forti demarcazioni per gli individui che successivamente colonizzano la stessa area. Nell'immagine riportata in fig. 5, questi effetti sono visibili in quanto rimangono "congelati" nel pattern durante il processo di sviluppo.

Vita artificiale

In una seconda versione dell'esperimento sono state introdotte diverse specie di individui e cambiato il fenotipo (reattività in relazione alla propria e alle altre specie) lasciandolo evolvere secondo il meccanismo della selezione naturale. In questo caso la probabilità di morte è connessa all'interazione tra le sole parti in crescita, pertanto il sistema non giunge alla conclusione della evoluzione (lo spazio vitale non decresce rapidamente ma varia in relazione al numero degli individui viventi), ma si autosostiene evolvendo attraverso la genetica. Per questi motivi, la seconda versione dell'esperimento è inquadrabile nei sistemi di vita artificiale che includono sia l'auto-organizzazione che la selezione naturale.

Poiché l'interazione è essenzialmente competitiva e si fonda su una caratteristica di fitness (funzione che misura la capacità di rimanere in vita), l'adattamento all'ambiente (evoluzione) si manifesta come la selezione degli individui che hanno una più elevata fitness. Pertanto la fitness media della popolazione cresce rapidamente.

In questo secondo esperimento, l'auto-organizzazione si manifesta attraverso lo sviluppo di stratificazioni sociali di ogni specie in due gruppi di individui differenziati: un gruppo ristretto (dominante) ad elevata fitness ed età media, e un gruppo ampio a bassa fitness ed alta mortalità. Gli individui deboli di una specie servono ad alimentare gli individui forti delle altre specie e viceversa. In sostanza si verifica una forma di auto-organizzazione funzionale in cui le specie, pur competendo tra loro, si alimentano a vicenda senza mai annientarsi. La situazione che emerge ricorda le società di formiche, molto cooperative all'interno del gruppo e molto aggressive all'esterno.

Solo un bel gioco?

Quanto abbiamo esemplificato, forse un tempo avrebbe potuto trovare spazio nelle rubriche di giochi matematici delle riviste scientifiche. Oggi non é più cosi ed intere istituzioni di ricerca lavorano su questi temi. Perché ?

La prima risposta è ovviamente quella dell'indagine sui meccanismi dei sistemi caotici complessi e dei sistemi viventi.

Una descrizione più ampia più essere trovata nel riquadro relativo alla storia delle teorie del caos e della complessità.

La seconda risposta, meno ovvia, è che questi concetti possono essere utilizzati anche per applicazioni tecnologiche.

Per chiarire con un semplice esempio, proviamo a scambiare la funzione di fitness descritta nel precedente paragrafo con una funzione di costo costruita su un compromesso tra rendimento ed emissione di inquinanti di un impianto di combustione e colleghiamo dinamicamente le misure effettuate sull'impianto (parametri di funzionamento) con le caratteristiche genetiche degli individui che nascono.

Scopo del gioco, stavolta, è lasciare evolvere il sistema selezionando dinamicamente gli individui (condizioni di impianto) che hanno portato a una migliore ottimizzazione della funzione di costo e indurre l'impianto verso questi parametri attraverso un sistema di controllo. Poiché l'adattamento è dinamico, il sistema è in grado di adattarsi a variazioni del processo (esempio: cambiamento del tipo di combustibile o riduzioni delle performances durante la vita dell'impianto) senza che questa informazione debba essere comunicata al sistema in evoluzione. Ormai è chiaro che l'obiettivo da raggiungere in questo caso è quello di trovare una strategia di controllo che permetta la ottimizzazione dinamica delle condizioni di funzionamento (è esattamente questo il tentativo attualmente in atto nella terza fase di questo studio).

Poiché il meccanismo di ottimizzazione genetica e di auto-adattamento che abbiamo utilizzato è del tutto generico, è facile capire come questa tecnica possa essere moltiplicata nelle applicazioni anche su tematiche notevolmente diverse tra loro.

Conclusioni necessariamente provvisorie

La più importante conclusione che si può trarre da questo sintetico panorama sui concetti del caos e della complessità potrebbe essere sintetizzata nell'impatto che hanno avuto e stanno avendo sulla cultura intesa nel suo insieme. Questo approccio si sta rapidamente diffondendo non soltanto nei settori scientifici ma anche nelle scienze sociali, nei linguaggi della comunicazione e della espressione artistica e culturale. Questo è il segno che queste idee stanno producendo un cambiamento di paradigma profondo e sono mature per generare una serie di promettenti ricadute applicative.

La condizione necessaria per fare questo, consiste nel tentativo di adattare teorie astratte a problemi che esigono risposte concrete e utilizzabili quali sono quelle della organizzazione di gruppi o problematiche industriali o tecnologie per il miglioramento della qualità della vita. In una parola si tratta di verticalizzare la teoria e tradurre i concetti in implementazioni.

Il carattere multidisciplinare e sistemico di queste scoperte, ha incrinato la visione classica della ricerca e delle categorie scientifiche così come sono venute a formarsi negli ultimi cento anni. Per generare nuove idee occorre ridefinire le discipline e i gruppi di ricerca integrando formazioni miste di carattere teorico (e non soltanto scientifico) e applicativo. In tal senso, l'esperienza del Santa Fé Institute (vedi riquadro sui laboratori di ricerca) dove confluiscono molte fonti culturali diverse, è decisamente interessante, dimostrando come anche le tematiche applicative possono giovarsi di apporti multidisciplinari. Le loro esperienze hanno evidenziato che i risultati applicativi possono ottenersi soltanto ampliando la visione della ricerca. Per farlo, occorre cambiare schema di pensiero e creare organizzazioni in cui scienza, cultura e tecnologia non siano più tre strati orizzontali adiacenti e separati ma possano essere tagliati verticalmente ridefinendo elasticamente i rapporti relativi in funzione degli obiettivi da raggiungere.

Riquadro1

Il Caos Deterministico

Le prime intuizioni sui sistemi caotici risalgono agli anni 1910-1930. Gli studi effettuati da H. Poincarè, G.D. Birkhoff e S. Smale evidenziarono come alcuni sistemi fisici non lineari mostrano traiettorie evolutive molto complesse la cui dinamica dipende fortemente dalle condizioni iniziali. In quegli anni, la tecnologia (calcolatori elettronici) non era matura per permettere un approfondimento delle intuizioni iniziali e probabilmente la concomitanza con altre scoperte importanti (la relatività e la teoria quantistica) contribuirono a limitare lo sviluppo di questa linea di pensiero fino agli anni '60.

Attrattori e frattali

Più tardi, furono proprio le simulazioni al computer di E. Lorenz [Lorenz, 1962] a mettere in risalto come un semplice sistema di tre equazioni differenziali non lineari mostri chiaramente la dipendenza dalle condizioni iniziali. Diverse simulazioni, condotte su un modello della circolazione atmosferica, pur partendo dalle medesime condizioni iniziali mostravano una divergenza che si amplificava nel tempo. Inoltre, i tempi cui si verificava la divergenza erano più lontani se si aumentava la precisione (in bit) utilizzata per la simulazione stessa. In sostanza per quanto fosse piccola la differenza tra le condizioni iniziali, queste si amplificavano nel tempo risultando in una

impredicibilità del sistema.

Osservando le traiettorie nello spazio delle fasi (fig. 1), Lorenz notò che aumentando la risoluzione con cui si osserva il sistema ogni traiettoria si sdoppia in due linee quasi coincidenti per un certo tratto. Egli mise in relazione questa caratteristica con un altro settore di ricerca che si sviluppò negli anni ‘70: la geometria frattale di cui più avanti daremo dei cenni. Dimostrò infatti che il suo attrattore aveva una dimensione non intera ma frazionaria (2.06). Per questo motivo chiamò il suo attrattore strange attractor, termine che viene attualmente utilizzato per indicare attrattori con dimensione frazionaria.

La geometria frattale fu introdotta da B. Mandelbrot negli anni '70 [Mandelbrot, 1983] con lo scopo di dare una descrizione formale della complessità delle forme naturali. Essa parte da una proprietà che si manifesta molto spesso nelle forme naturali: l'autosomiglianza, ossia la somiglianza tra le parti e il tutto. Nel tentativo di descrivere una invariante che caratterizzasse l'autosomiglianza, Mandelbrot approdò alla ridefinizione del concetto di misura. L'esempio provocatorio (e ormai famoso) che egli propose per spiegare questa necessità fu quello della misura della lunghezza della costa della Gran Bretagna. Egli mostrò che la misura cambiava in funzione della lunghezza dello strumento utilizzato per la misura (righello). È abbastanza evidente che utilizzando righelli da dieci chilometri, da un metro, o da un micron per ottenere questa misura, otterremo risultati dipendenti dalla unità utilizzata.

Mandelbrot individuò una relazione tra queste misure apparentemente casuali facendo ricorso ad una grandezza introdotta da Hausdorff nel 1919. Egli notò che il rapporto tra il logaritmo del risultato della misura (numero N delle unità di misura) e il logaritmo dell'inverso del valore della unità di misura (r) assume un valore costante (D).

D = log(N) / log(1/r)

La variabile D rappresenta il grado di frastagliatura di una linea e poiché in natura assume sempre dimensioni frazionarie, fu chiamata da Mandelbrot dimensione frattale.

L'importanza degli studi di Lorenz fu quella di stabilire un collegamento tra la descrizione frattale e gli attrattori introducendo così una delle più interessanti invarianti della dinamica (la dimensione frattale) che caratterizza la evoluzione temporale di un sistema.

Biforcazioni e analisi dinamica dei sistemi caotici

Successivamente alle prime idee di Lorenz e Mandelbrot, la teoria del caos si è articolata in una serie di studi e di branche e ha costituito l'ossatura della maggior parte delle indagini sulla dinamica dei sistemi.

Già negli anni '60 e successivamente negli anni '70 il matematico francese René Thom [Thom, 1975] con la Teoria delle Catastrofi anticipò quello che sarebbe stato uno dei principali approcci degli anni successivi.

Le catastrofi furono definite come momenti di passaggio (successivamente indicate come biforcazioni) tra differenti stati di equilibrio in relazione a variazioni anche piccole di parametri di controllo del sistema. Thom studiò e classsificò le modalità sotto cui questi eventi avvengono, in relazione a quanti parametri vengono contemporaneamente cambiati.

Una delle prime applicazioni modellistiche dell'analisi dei sistemi caotici di notevole rilevanza fu la revisione dell'approccio classico alla turbolenza da parte di Ruelle e Takens [Ruelle, Takens, 1971]. Essi ipotizzarono che la turbolenza fosse il risultato di un particolare regime dell'attrattore nelle equazione di Navier Stokes. Fu mostrato che il raggiungimento del regime turbolento avveniva attraverso il passaggio di una serie di Biforcazioni di Hopf, ossia il passaggio nell'attrattore da un punto fisso a un'orbita periodica, successivamente a un'orbita pseudoperiodica toroidale e, infine, a un attrattore strano [Ruelle, 1987]. Infine, essi confermarono questa teoria attraverso una serie di esperimenti con fluidi reali.

Il concetto di biforcazione come un cambiamento qualitativo nella struttura dell'attrattore, è stato ampiamente ripreso e studiato negli anni successivi; poiché le modalità di biforcazione sono in numero limitato, esse costituiscono la base per molti studi di modellistica il cui scopo principale è quello di scoprire quali sono i meccanismi che inducono il caos in un sistema e risalire quindi alle caratteristiche del modello stesso. Questa branca di ricerca viene identificata come qualitative dynamics e mette l'accento sulla caratteristica multidisciplinare della teoria del caos in quanto ricerca fenomenologie comuni a molti sistemi.

Uno degli esempi più noti è il meccanismo di progressione caotica del period doubling che dà luogo a straordinarie somiglianze di comportamento tra fenomeni molto diversi tra loro e consiste nel progressivo raddoppio del numero degli stati assunti dal sistema allorché un parametro esterno viene variato.

L'analisi dei sistemi caotici reali

A partire dagli anni '80, sono stati sviluppati una serie di concetti che hanno creato un legame tra la Teoria del Caos Deterministico e le applicazioni in campo industriale e oggi costituiscono il nodo tra la scienza e la tecnologia dei sistemi caotici. In particolare, questi studi focalizzano la loro attenzione sull'analisi di segnali provenienti da sensori installati su sistemi caotici o presunti tali. Le principali applicazioni riguardano lo sviluppo di modelli, la classificazione, la predizione, il controllo e la sincronizzazione dei sistemi caotici.

Questi sistemi spesso presentano un grado di complessità notevole sia per la mancanza di adeguati modelli teorici e sia a causa della presenza di rumore nei segnali dovuti a fenomenologie concomitanti che mascherano parzialmente la dinamica causando un aumento artificiale della dimensionalità.

Malgrado gli studi sui sistemi caotici fossero intrapresi negli anni '60-'70, soltanto all'inizio degli anni '80 [Takens, 1981] furono applicate tecniche di ricostruzione degli attrattori relativi a segnali di sistemi reali. Le difficoltà nella ricostruzione dello spazio delle fasi sono insite nel fatto che generalmente si dispone di una sola o di poche variabili che governano il sistema e quindi non era chiaro come si potesse passare da osservazioni univariate alla dinamica multivariata.

A dare soluzione a questi problemi e ad aprire la strada alle applicazioni fu l'Embbedding Theorem attribuito a Takens e Manè [Manè, Rand, Young, 1981; Takens, 1981]. La più importante conseguenza che ne deriva è che, sotto alcune ipotesi, è possibile ricostruire la dinamica del sistema multivariato utilizzando i valori ritardati nel tempo su una sola variabile. Lo spazio cosi ricostruito prende il nome di Embedded Phase Space.

Dal punto di vista concettuale, significa che nella evoluzione temporale di ogni singola variabile è contenuta l'influenza di tutte le altre.

Gli studi si sono quindi concentrati su due problemi fondamentali: come identificare il tempo di ritardo (time lag) e come determinare la dimensionalità dello spazio. Uno dei maggiori apporti in questa direzione è stato dato da Abarbanel [Abarbanel, 1996] con una serie di funzioni e prescrizioni su come identificare questi parametri ed ottenere una corretta ricostruzione dell'attrattore.

Le invarianti della dinamica

Uno dei settori di sviluppo più importanti nell'analisi caotica è costituita dalla ricerca di invarianti della dinamica. Cioè di grandezze in grado di descrivere in modo ripetitivo il comportamento dinamico di un sistema. Queste quantità sono pensate come quantità statistiche di un sistema deterministico e sono invarianti rispetto alle condizioni iniziali. La ricerca in questo settore si è concentrata soprattutto su due caratteristiche: la dimensione frattale e i coefficienti di Lyapunov che di seguito illustreremo.

La dimensione frattale è stata già incontrata nei precedenti paragrafi. Introdotta da Mandelbrot per caratterizzare le forme e legata agli attrattori da Lorenz [Lorenz, 1963], è stata ampiamente studiata per definire le modalità con cui il sistema si muove nello spazio delle fasi. Al di là dei procedimenti matematici utilizzati per il calcolo [Grassberger, Procaccia, 1983; Casdagli, Sauer, Yorke, 1991], si può dire che la dimensione frattale rappresenta il modo in cui i punti dell'attrattore sono distribuiti nello spazio delle fasi.

Sfortunatamente, mentre questa discriminante è molto utile per i sistemi teorici, il suo utilizzo per i sistemi reali è limitato dalla presenza di rumore esterno [Abarbanel, 1996].

L'altra invariante, meno sensibile al rumore, è il coefficiente di Lyapunov. In termini semplici, si può dire che il coefficiente di Lyapunov esprime l'evoluzione nel tempo della distanza nell'attrattore tra due punti inizialmente vicini:

d(t) = d(to) e _(t-to)

dove _ è il coefficiente di Lyapunov.

Nei sistemi regolari o pseudoperiodici questa distanza rimane costante o diminuisce (_ negativo o nullo) mentre nei sistemi caotici diverge esponenzialmente (_ positivo). Poiché il coefficiente di Lyapunov può essere visto anche come la tendenza alla divergenza delle orbite dell'attrattore, nei sistemi caotici il suo valore rappresenta il grado di caoticità del sistema. In questi termini, può essere ridefinito anche il concetto di sistema caotico come un sistema caratterizzato da almeno un coefficiente di Lyapunov positivo (per un sistema non lineare a n gradi di libertà esistono n coefficienti di Lyapunov), cioè un sistema in grado di produrre informazione e generare entropia. (Rabinovich, 1978).

Riquadro 2

Auto-organizzazione e Complessità

Tra i primi ricercatori che proposero il concetto di Auto-Organizzazione (Self-Organization) furono Ross Ashby [Ashby, 1962] e Heinz von Foerster negli anni '60 che evidenziarono le proprietà di alcuni sistemi complessi di sviluppare strutture ordinate da situazioni localmente caotiche.

Il premio Nobel Ilya Prigogine [Prigogine, Stengers, 1984] fu il primo a definire approfonditamente le modalità e le condizioni in cui si sviluppano i comportamenti auto-organizzanti. Per semplificare il problema, egli si rivolse dapprima verso lo studio di quei sistemi fisici e chimici che manifestano queste proprietà [Prigogine, Glansdorff, 1971].

È importante notare che l'auto-organizzazione si manifesta non soltanto nei sistemi costituiti da esseri viventi, ma anche in una serie di sistemi fisici e chimici. Alcuni semplici esempi sono le transizioni di fase (i.e. da liquido a solido, dove il sistema acquisisce improvvisamente e spontaneamente struttura e complessità), gli effetti di magnetismo (allineamento dei micromagneti), gli effetti di conducibilità elettrica (superconduttori). Tra i casi studiati a fondo, i più noti sono la instabilità di Benard (comparsa di vortici stabili per effetto della convezione naturale) e la reazione di Belousov-Zhabatinski (pulsazioni chimiche intermittenti). In tutti questi sistemi un comportamento globale strutturato emerge come frutto dell'interazione caotica di molti singoli elementi.

La principale conclusione degli studi di Prigogine è che l'auto-organizzazione si manifesta in sistemi dissipativi (quindi attraversati da un flusso di energia) lontani dall'equilibrio. Inoltre la condizione migliore per la comparsa di questi effetti è quella in cui il sistema si trova sul bordo del caos (Edge of Chaos) in cui si passa da uno stato ordinato verso gli stati pienamente caotici attraverso serie di biforcazioni. In queste condizioni si verificano meccanismi di selezione a causa della forte sensibilità alle condizioni iniziali.

Una delle applicazioni più importanti di questi concetti fu lo sviluppo del modello del laser di Haken. Egli sviluppò una teoria non lineare del laser riconducendo il fenomeno ad un processo di auto-organizzazione in cui i treni d'onda luminosi manifestano un comportamento cooperativo in presenza di condizioni lontane dall'equilibrio. Egli coniò il termine sinergetica come una nuova scienza per lo studio di questi effetti cooperativi [Haken, 1977].

Automi cellulari

La progressione della idea di auto-organizzazione stimolò molti settori di ricerca tra cui la cibernetica, le neuroscienze e la biologia. Con l'avvento dei primi computer iniziarono i tentativi di simulazione dei meccanismi naturali dell'intelligenza e della autoorganizzazione.

I più significativi furono l'avvento delle reti neurali con le prime esperienze di McCulloch e Pitts nel 1943 [Mc Culloch, Pitts, 1943] e gli automi cellulari introdotti da J. Von Neumann [Von Neumann, 1966] per tentare lo sviluppo di macchine in grado di autoriprodursi.

Gli automi cellulari (Cellular Automata) sono reticoli (mono- o bidimensionali) di celle il cui valore binario (o comunque discreto) dipende in modo dinamico, dai valori delle celle adiacenti e dal suo precedente valore.

Uno degli esempi più diffusi è il gioco Life di J. Conway.

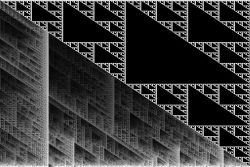

Gli automi cellulari furono studiati in dettaglio da S. Wolfram [Wolfram, 1986] che ne studiò i meccanismi di crescita e ne evidenziò le caratteristiche di autorganizzazione.

Egli dimostrò come, anche utilizzando regole di interazione locale molto semplice, l'effetto globale è quello di sviluppare pattern molto complessi ed evoluzioni che ricordano i meccanismi di riproduzione. In fig. 6 è riportato un esempio di automa in cui si manifestano contemporaneamente strutture molto ordinate e strutture fortemente caotiche.

Una conclusione fondamentale è che "anche partendo da un insieme nel quale ciascuna configurazione possibile appare avere uguale probabilità, l'evoluzione dell'automa cellulare concentra le probabilità per configurazioni particolari riducendo l'entropia" [Wolfram, 1986]. Questo significa che l'entropia degli stati di un automa può diminuire producendosi ordine dal disordine. Il contrasto con il secondo principio della termodinamica viene risolto nel fatto che le regole degli automi cellulari danno luogo a processi di tipo irreversibile e quindi sfuggono alle limitazioni imposte dal secondo principio [Davies, 1989].

Un settore dove gli automi cellulari sono stati largamente utilizzati è la biologia. In particolare S. Kaufmann [Kaufmann, 1993] ha creato diversi automi (Random Boolean Networks) per simulare alcuni aspetti dell'autoadattamento dei sistemi biologici. Una delle principali conclusioni è che la selezione naturale non è il più importante meccanismo evolutivo, ma è proprio il comportamento auto-adattante che può imprimere notevole velocità all'evoluzione attraverso l'aumento progressivo della complessità.

Evolutionary Computing

L'altro fronte di indagine che è stato oggetto di diverse applicazioni è il meccanismo della selezione naturale.

Questo meccanismo è stato sfruttato con notevole successo per una serie di applicazioni industriali che vanno dalla progettazione al controllo real-time, all'addestramento delle reti neurali.

Le prime realizzazioni nacquero a metà degli anni '60 per risolvere problemi di ottimizzazione con Algoritmi Genetici che si fondavano sui tre meccanismi di base della Teoria della Evoluzione: la riproduzione, la mutazione, la capacità di sopravvivenza (nel linguaggio computazionale: fitness).

Successivamente, a partire dagli anni '70-'80 [Holland, 1975] questo settore si è sviluppato notevolmente diversificandosi su diversi approcci di base e includendo anche altri meccanismi come ad esempio la ricombinazione (scambio di informazioni tra i sopravvissuti). In particolare si sono creati quattro differenti approcci (Genetic Algorithms, Genetic Programming, Evolutionary Programming, Evolution Strategies) che si differenziano in base allo spostamento del peso sulla ricombinazione o sulla mutazione o sulle caratteristiche della funzione di fitness che governa il meccanismo della sopravvivenza.

Il termine Evolutionary Computing é utilizzato per indicare genericamente tutti gli approcci fondati sulla genetica [Rocha, 1997].

Occorre notare che benché l'ottimizzazione del sistema venga ottenuta attraverso una popolazione di individui, i sistemi fondati su questo approccio non sono considerati auto-organizzanti in quanto la loro dinamica dipende dal vincolo esterno della funzione di fitness e non viene sviluppato da una dinamica interna, mentre le mutazioni sono randomiche e non deterministiche come nei sistemi auto-organizzanti. Essi invece modellano un aspetto differente dei sistemi biologici: quello della selezione naturale.

Vita Artificiale

Verso la fine degli anni '80 cominciò a svilupparsi uno degli ultimi punti di arrivo (o meglio di partenza) degli studi sulla complessità. Questo approccio si basa sulla fusione dei due concetti espressi in precedenza: l'autorganizzazione e i sistemi evoluzionari.

La spinta verso questa fusione è venuta dagli studi sui meccanismi presenti nei sistemi biologici quali metabolismo, adattabilità, autonomia, auto-riparazione, crescita, replicabilità, reattività, evoluzione, autoreferenziazione (i meccanismi in base a cui l'organizzazione mette in atto azioni e comportamenti funzionali in riferimento all'organizzazione stessa Rocha, 1997]).

La prima grande difficoltà in cui si imbatterono questi studi fu la stessa definizione di vita, cioè la distinzione tra essere vivente e non vivente. Questo dibattito vide lo sviluppo di molte definizioni che si differenziano anche in termini sostanziali. Uno dei perni fondamentali su questo dibattito fu posto da Maturana e Varela, i quali svilupparono il concetto di Autopoiesi come caratteristica esclusiva dei sistemi viventi [Maturana, Varela, 1973]. L'Autopoiesi è una rete di processi di produzione, in cui la funzione di ogni componente è quella di partecipare alla produzione o alla trasformazione di altri componenti della rete. In due parole: la produzione del sé.

Questo dibattito ha stimolato fortemente i tentativi di simulazione al computer di sistemi che avessero le caratteristiche autopoietiche. Un esempio significativo sono gli studi sulle reti neurali che hanno visto la fioritura di una serie di varianti per simulare meccanismi di memoria [Memorie Associative, Hopfield, 1983], di auto-organizzazione [Self-Organizing Map], e di autopoiesi [Reti Autopoietiche, Reti Self-Reflexive], in cui il target si definisce e si stabilizza nel corso dell'apprendimento].

Molti tentativi vengono oggi fatti per simulare alcune caratteristiche tipiche degli esseri viventi. Questa disciplina va sotto il nome di Vita Artificiale (Artificial Life o Alife). Queste simulazioni prendono le distanze da eccessive aspettative e, come Langton [Langton, 1989] puntualizza, si occupano non della vita-come-è, bensì della vita-come-potrebbe-essere e pongono l'accento sulla vita artificiale come comportamento emergente.

Nel contesto della Vita Artificiale essi generalizzano alcuni concetti come i genotipi (specificazioni per un set di macchine) e i fenotipi (il comportamento risultante quando le macchine interagiscono) che possono anche evolvere attraverso cambiamenti di forma (morfogenesi) nell'ottica ibrida della selezione naturale e della auto-organizzazione. Il vantaggio di questi sistemi ibridi è ovviamente quello di sfruttare due potenzialità importanti: quello della ottimizzazione evolutiva e quello della elaborazione di nuove strutture interne per il raggiungimento delle soluzioni più adatte.

Per queste caratteristiche, questi sistemi costituiscono una importante promessa e sono guardati con molto interesse anche in settori applicativi, dove lo scopo non è quello di simulare la vita ma dare la migliore risposta tecnologica a un problema prefissato.

Fig. 6: Automa Cellulare (M. Annunziato). Questa automa mostra chiaramente il confine emergente tra due zone di sviluppo: una organizzata rigidamente ed una fortemente caotica.

Riquadro 3

Principali Istituti di ricerca

Uno dei centri di ricerca che costituiscono un riferimento storico per la modellistica dei sistemi caotici è il Center for Nonlinear Studies (CNS) del Los Alamos National Laboratory gestito dalla University of California per conto del Dipartimento di Energia (DOE) degli Stati Uniti. I concetti della dinamica non lineare sono investigati per sviluppare nuovi modelli in diversi campi che vanno dalla fisica alla chimica ed alla scienza dei materiali. Le teorie sulla autorganizzazione sono studiate per modellare l'emergenza di pattern e la loro dinamica nelle problematiche di termofluidodinamica e della crescita granulare dei materiali.

Abbastanza simili sono le tematiche affrontate dal Center for Nonlinear Dynamics (CND) della University of Texas di Austin (Prof. McCormick) particolarmente orientate verso la fluidodinamica, chimica e la scienza dei materiali. Per quanto riguarda la teoria della auto-organizzazione, di particolare interesse è il Ilya Prigogine Center for Studies in Statistical Mechanics and Complex Systems diretto a suo tempo dal premio Nobel Ilya Prigogine ed ora intitolato The Center for Complex Quantum Systems.

Molto significativo è il Chaos Group della University del Maryland da tempo impegnato sulla dinamica non lineare (importanti i contributi del Prof. Ott, Prof. Grebogi e Prof. Yorke, cui si deve la prima definizione in senso scientifico del termine chaos) nell'ambito di molti temi teorici ed alcune problematiche applicative.

Per quanto riguarda la analisi di sistemi caotici reali uno dei centri di riferimento è senza dubbio l'Institute for Nonlinear Science (INLS) della University of California San Diego (Prof. Abarbanel, Prof. Fischer, Prof. Rabinovich) sia per la consistenza del gruppo che per i risultati ottenuti in questo settore molto recente.

Di forte interesse applicativo sono altri due centri: il Chaos Research Group presso l'University of Tennesse (UTK, College of Engineering), il Chaos Applications Group (Prof. Daw) dell'Oak Ridge National Laboratory (ORNL, Engineering Technology Division, Diagnostic Applied Research Center). In particolare presso l'UTK si applicano le teorie del caos su due temi fondamentali: la combustione (combustori industriali, combustione pulsata e motori a combustione interna) e il multifase (letti fluidi, sistemi a colonne di bolle).

Presso l'ORNL l'accento è posto sulla diagnostica e sul controllo industriale.

In Europa vi sono diversi centri importanti in Gran Bretagna, Germania ed Olanda, tra cui il Centre for Nonlinear Dynamics (Prof. Bishop, Prof. Thompson, Prof. Stark) dell'University College di Londra, il Chaos Group collegato alla Università di Monaco, e i gruppi di ricerca che fanno capo al Prof. Takens (Università di Groningen, Università di Delft) in Olanda. Tutti questi gruppi hanno un carattere applicativo nel campo dell'ingegneria.

Per quanto riguarda gli studi sulla complessità, il centro più interessante è sicuramente il Santa Fé Institute creato nel 1984 e interamente dedicato alla Scienza della Complessità. Questo istituto si presenta come multidisclipinare e fortemente collegato ad altri enti di ricerca. Le ricerche vanno dalla genetica alla vita artificiale, dagli automi cellulari ai sistemi ad apprendimento distribuito, per essere applicati in diversi contesti scientifici. Tra i ricercatori che figurano nel faculty staff esterno vi sono nomi importanti quali S. Kauffman, J. Crutchfield, M. Feldman, D. Griffeath, T. Ray.

1. H.D.I. ABARBANEL. Analysis of Observed Chaotic Data, Ed. Springer-Verlag, New York (1996).

2. M. ANNUNZIATO, S. PIZZUTI, I. BERTINI, Cooperation between Fluidynamic and Neural-Fuzzy Models for Monitoring Multiphase Flows, Third Int. Conference on Multiphase Flow, Lyon, France, 1998.

3. M. ANNUNZIATO, I. BERTINI, S. PIZZUTI, Applicazione di reti neurali e logica sfumata per la diagnostica e controllo di pozzi petroliferi. Conferenza su Cambiamento e Complessità nelle Organizzazioni, Roma, Centro Congressi Alitalia, Settembre, 1997.

4. M. ANNUNZIATO, H.D.I. ABARBANEL, Non linear dynamics for classification of multiphase flow regimes. Int. Conf. on Soft Computing, SOCO, Genova, 1999.

5. M. ANNUNZIATO, The Nagual Experiment. Int. Conf. on Generative Art, Milano, 1998.

6. W.R. ASHBY. Principles of the Self-Organizing System. In : Principles of Self-Organization. H. Von Foerster and G.W. Zopf (Eds.). Pergamon Press. 1962.

7. F. CAPRA. The Web of Life, Doubleday-Anchor book, New York, 1996 (Trad. it. La rete della vita, Ed. Rizzoli, Milano, 1997).

11. M. CASDAGLI, T. SAUER, J.A.YORKE. Embedology. J. Stat. Phys., 65 :579-616, 1991.

12. C. CASTANEDA. Tales of Power. Simon and Schuster, New York, 1972.

13. M. CINI. Il paradiso perduto. Feltrinelli, Milano, 1994.

14. P. DAVIES. Il Cosmo intelligente, Ed. Mondadori, Milano, (1989).

15. EMMECHE. The Garden in the Machine: The Emerging Science of Artificial Life. Princeton Univ. Press, 1991.

16. J. GLEICK. Making a New Science. Viking, New York, 1987 (trad. it. Sosio, Caos, Rizzoli, Milano 1989).

17. P. GRASSBERGER, I. PROCACCIA. Characterization of Strange Attractors. Phys. Rev. Letters, 50:346-349, 1983.

18. H. HAKER, Synergetics. Springer-Verlag, 1977.

19. J.H. HOLLAND. Adaption in Natural and Artificial Systems. University of Michigan Press. 1975.

20. J.J. HOPFIELD, D.I. FEINSTEIN, R.G. PALMER, Unlearning has a Stabilizing Effect in Collective Memories. Nature, 304, 1983, p. 158.

21. C. LANGTON. Artificial Life. C. Langton Ed. Addison-Wesley. pp. 1-47, 1989.

22. E. LORENZ. Deterministic Nonperiodic Flow. Journal of the Atmospheric Science, vol. 20, pp. 130-141, 1963.

23. S.A. KAUFFMANN. The Origins of Order: Self-Organization and Selection in Evolution. Oxford Univ.Press, 1993.

24. G.J. KLIR, Facets of Systems Science. Plenum Press. 1991.

25. B. MANDELBROT. The Fractal Geometry of Nature. Freeman, New York, 1983. (trad. it. La geometria della natura. Sulla teoria dei frattali, Imago, Milano 1987).

26. 30. R. MANÈ, D. RAND, L.S. YOUNG, editors, Dynamical Systems and Turbolence, Warwick 1980, pag. 366, Springer, Berlin, 1981.

27. H. MATURANA, F. VARELA. Autopoiesis: The Organization of the Living. 1973. (trad. it. Orellana, Macchine ed esseri viventi. L'Autopoiesi e l'organizzazione biologica. Astrolabio-Ubaldini Editore, Roma 1992).

28. W.S. McCULLOCH, W.H. PITTS, A Logical Calculus of the Ideas Immanent in Nervous Activity, Bullettin of Mathematical Biophysics, vol. 5, p. 115, 1943.

29. I. PRIGOGINE, I. STENGERS. Order out of Chaos. Bantam, New York 1984 ( trad. it. La nuova alleanza, Einaudi, Torino 1981).

30. I. PRIGOGINE, P. GLANSDORFF, Thermodinamic Theory of Structure, Stability and Fluctuations, Wiley, New York 1971.

31. I. PRIGOGINE, From Being to Becoming, Freeman, San Francisco 1980. (trad. it. Di Bocchi, Cerruti, Dall'essere al divenire, Einaudi, Torino 1986).

32. M.I. RABINOVICH. Stochastic Self-Oscillations and Turbolence. Sov. Phys. Usp., Volume 21, pp 443-469, 1979.

33. L.M. ROCHA, Evolutionary Systems and Artificial Life, Lecture Notes, Los Alamos National Laboratory, 1997.

34. D. RUELLE, F. TAKENS, 1971, Comm. Math. Phys. 21, 12.

35. D. RUELLE, Chaotic Evolution and Strange Attractors, Cambridge University Press, Cambridge, 1987.

36. C. SODDU, The Design of Morphogenesis. An experimental research about the logical procedures in design processes. Demetra Magazine, 1993.

37. F. TAKENS. Detecting Strange Attractors in Turbolence. In R. Manè, D. Rand, L.S. Young, Editors, Dynamical Systems and Turbolence, Warwick 1980, pag. 366, Springer, Berlin, 1981.

38. R. THOM, Structural Stability and Morphogenesis, Benjamin, Reading, 1975, (Trad. it. Stabilità e Morfogenesi, Einaudi, Torino, 1980).

39. J. Von NEUMAN, The Theory of Self-Reproducing Automata. Arthur Burks Ed. Univ. of Illinois Press, 1966.

40. T. VICSEK. Fractal Growth Phenomena. World Scientific. Press. 1991.

41. S. WOLFRAM. Theory and Applications of Cellular Automata, World Scientific Press. 1986.

* Il saggio è stato pubblicato sul sito Plancton. Art of life and chaos e in Energia, ambiente, Innovazione, dic.. 98, ENEA monthly Rewiev.

** Mauro Annunziato fonda nel '94 il gruppo di arte digitale Plancton con Piero Pierucci, entrambi ricercatori/artisti impegnati nell'arte generativa e nelle scienze cognitive. Le installazioni interattive di Plancton sono state esposte in contesti e festival internazionali sulle arti emergenti (Siggraph, Imagina, Biennale di Mosca, Alife, Dart, Vida, Generative Art, Virtuality, Opera Totale, Artware) con diversi riconoscimenti (Annunziato è stato selezionato nel 2000 dalla NASA-JPL tra i "top 60 artist-scientist" scelti per dare un contributo culturale al primo villaggio umano su Marte (http://mmp.planetary.org/scien); la rivista d'arte internazionale Leonardo (MIT Press) ha dedicato ad un opera di Annunziato la copertina di giugno 2004. Il lavoro espressivo è intimamente fuso con un'attività di ricerca scientifica. Annunziato, laureato in ingegneria nucleare, autore di più di cento pubblicazioni scientifiche, è stato dal '96 al 2007 direttore di un laboratorio di ricerca in ENEA su Intelligenza e Vita Artificiale, ed ora dirige una unità dell'ENEA sullo sviluppo di tecnologie, metodi e diffusione dello sviluppo sostenibile e della efficienza energetica.

Torna in biblioteca